ClickHouse Cloud

Этот вариант предназначен для пользователей, использующих ClickHouse Cloud. В этой модели развертывания как ClickHouse, так и HyperDX размещены в ClickHouse Cloud, минимизируя количество компонентов, которые пользователю необходимо самостоятельно развертывать.

Помимо сокращения управления инфраструктурой, эта модель развертывания обеспечивает интеграцию аутентификации с ClickHouse Cloud SSO/SAML. В отличие от развертываний на собственных серверах, также нет необходимости provision a MongoDB instance для хранения состояния приложения — такого как панели инструментов, сохраненные запросы, настройки пользователей и оповещения.

В этом режиме прием данных полностью зависит от пользователя. Вы можете загружать данные в ClickHouse Cloud, используя свой собственный размещенный сборщик OpenTelemetry, прямую загрузку из клиентских библиотек, нативные движки таблиц ClickHouse (такие как Kafka или S3), конвейеры ETL или ClickPipes — управляемый сервис загрузки ClickHouse Cloud. Этот подход предлагает самый простой и самый производительный способ работы с ClickStack.

Подходит для

Эта модель развертывания идеальна в следующих сценариях:

- У вас уже есть данные наблюдаемости в ClickHouse Cloud, и вы хотите визуализировать их с помощью HyperDX.

- Вы управляете крупным развертыванием наблюдаемости и нуждаетесь в специализированной производительности и масштабируемости ClickStack с ClickHouse Cloud.

- Вы уже используете ClickHouse Cloud для аналитики и хотите инструментировать свое приложение, используя библиотеки инструментирования ClickStack, отправляя данные в тот же кластер. В этом случае мы рекомендуем использовать хранилища для изоляции вычислений для рабочих нагрузок наблюдаемости.

Шаги развертывания

Следующее руководство предполагает, что вы уже создали сервис ClickHouse Cloud. Если вы еще не создали сервис, следуйте шагу "Создание сервиса ClickHouse" из нашего руководства по быстрому началу.

Скопировать учетные данные сервиса (по желанию)

Если у вас уже есть события наблюдаемости, которые вы хотите визуализировать в вашем сервисе, этот шаг можно пропустить.

Перейдите к основному списку сервисов и выберите сервис, в котором вы хотите визуализировать события наблюдаемости с помощью HyperDX.

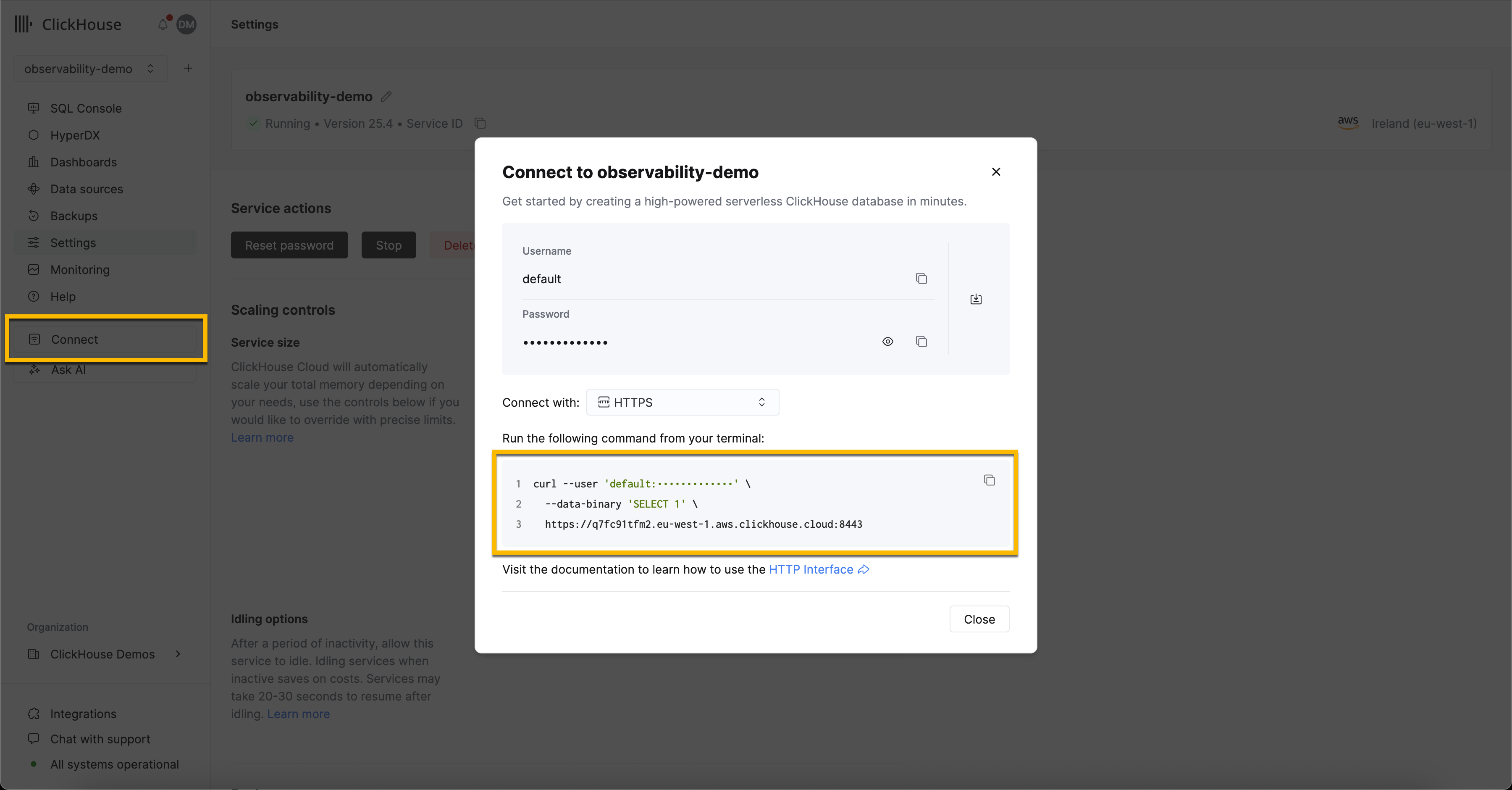

Нажмите кнопку Connect в навигационном меню. Откроется модальное окно с учетными данными вашего сервиса и набором инструкций о том, как подключиться через различные интерфейсы и языки. Выберите HTTPS из выпадающего списка и запишите конечную точку подключения и учетные данные.

Развертывание сборщика Open Telemetry (по желанию)

Если у вас уже есть события наблюдаемости, которые вы хотите визуализировать в вашем сервисе, этот шаг можно пропустить.

Этот шаг гарантирует, что таблицы создаются с помощью схемы Open Telemetry (OTel), которая может быть использована для создания источника данных в HyperDX. Это также предоставляет OLTP-эндпоинт, который может быть использован для загрузки примеров наборов данных и отправки событий OTel в ClickStack.

Следующие инструкции используют стандартное распределение сборщика OTel, а не распределение ClickStack. Последнее требует сервера OpAMP для настройки. Это в настоящее время не поддерживается в закрытой предварительной версии. Конфигурация ниже воспроизводит версию, используемую распределением ClickStack, предоставляя OTLP-эндпоинт, на который могут быть отправлены события.

Скачайте конфигурацию для сборщика OTel:

otel-cloud-config.yaml

Разверните сборщик, используя следующую команду Docker, установив соответствующие переменные окружения в соответствии с ранее записанными настройками подключения и используя соответствующую команду ниже в зависимости от вашей операционной системы.

В производственной среде мы рекомендуем создать выделенного пользователя для загрузки, ограничив права доступа к необходимым базам данных и таблицам. См. "Пользователь базы данных и загрузки" для получения дополнительных сведений.

Подключение к HyperDX

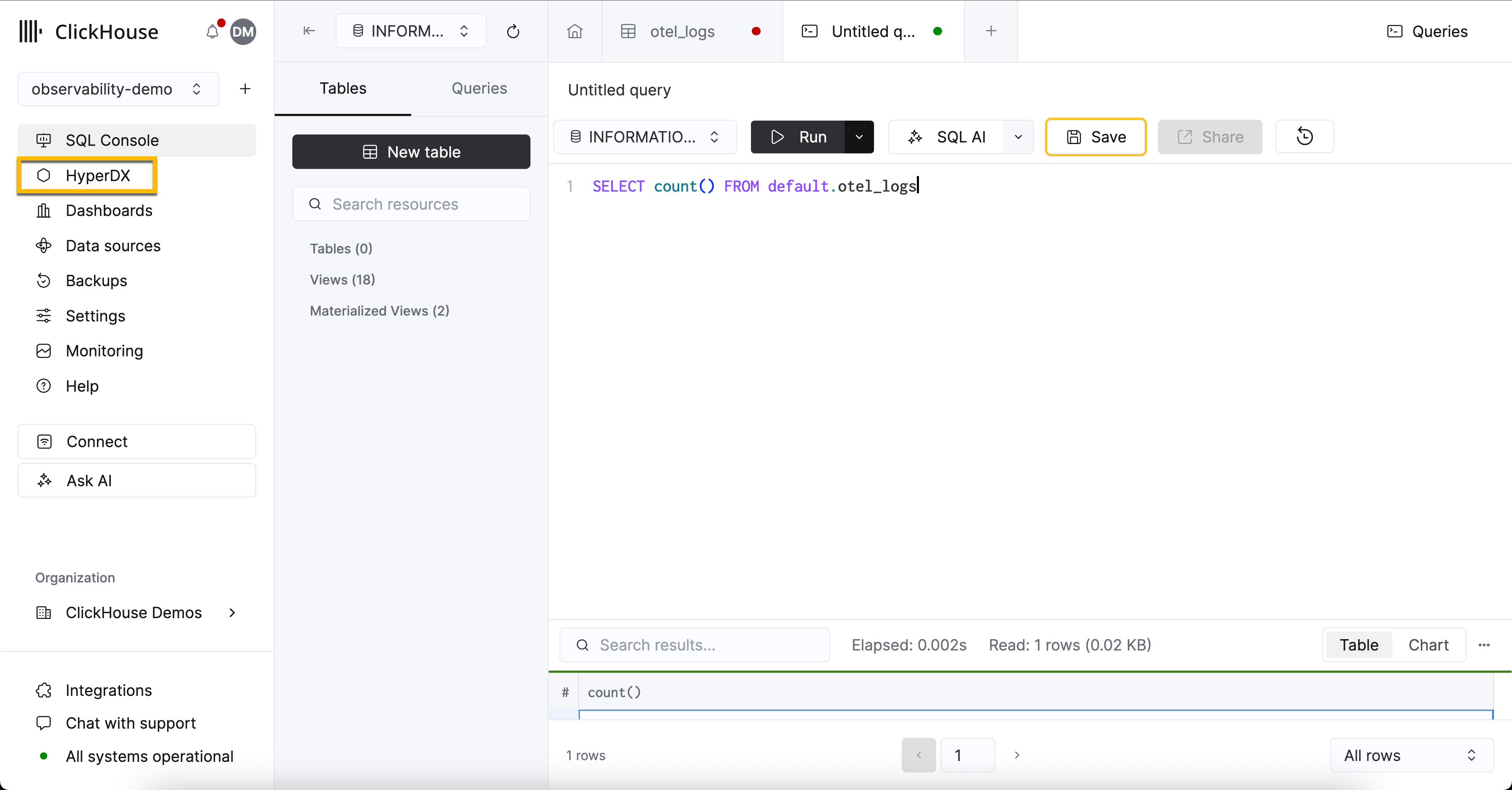

Выберите свой сервис, затем выберите HyperDX в левом меню.

Вам не нужно будет создавать пользователя, вы будете автоматически аутентифицированы, после чего вам будет предложено создать источник данных.

Для пользователей, желающих только изучить интерфейс HyperDX, мы рекомендуем наши пример наборов данных, которые используют данные OTel.

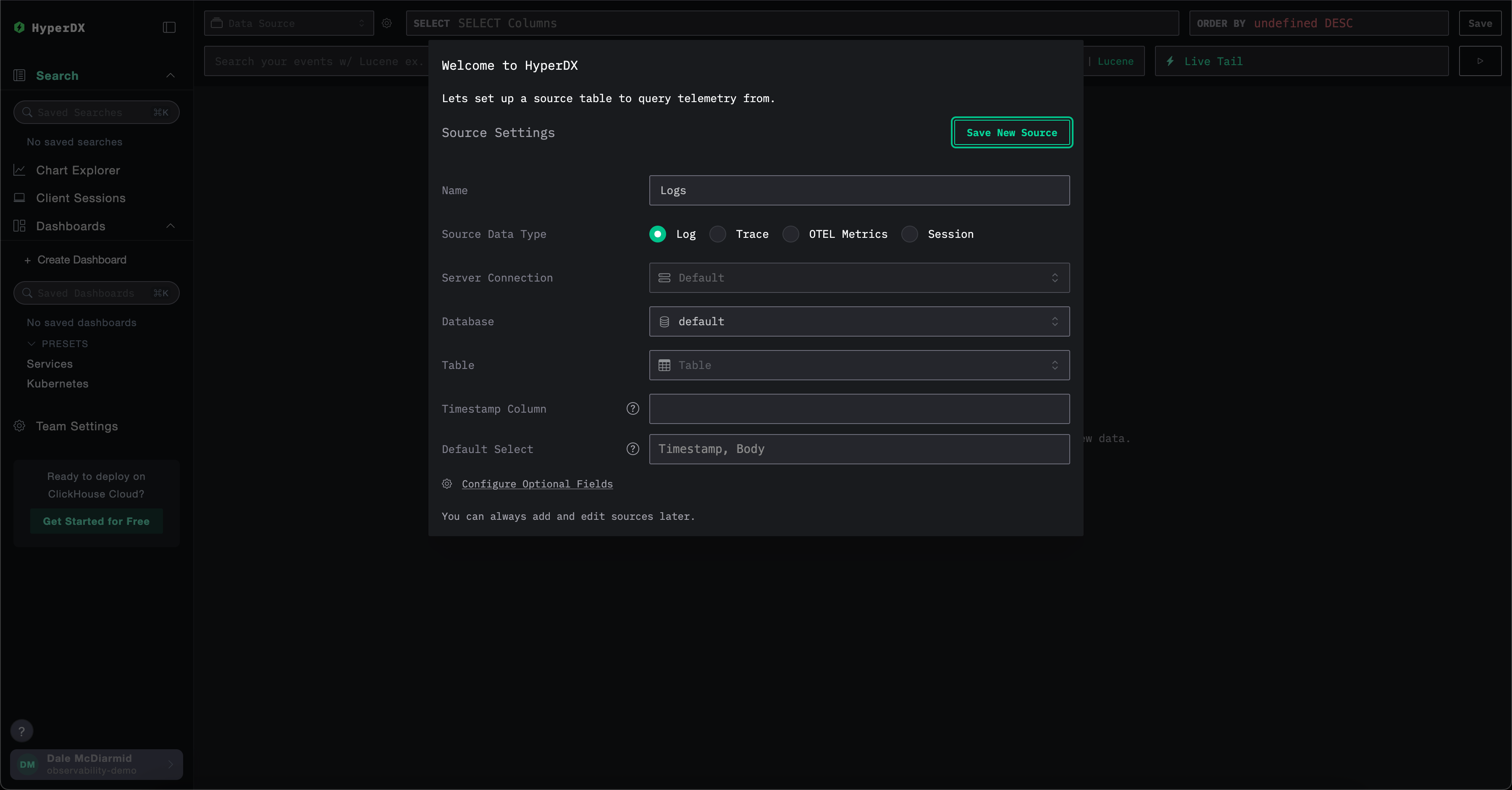

Создание источника данных

HyperDX является нативным для Open Telemetry, но не эксклюзивен для Open Telemetry - пользователи могут использовать свои собственные схемы таблиц, если это необходимо.

Использование схем Open Telemetry

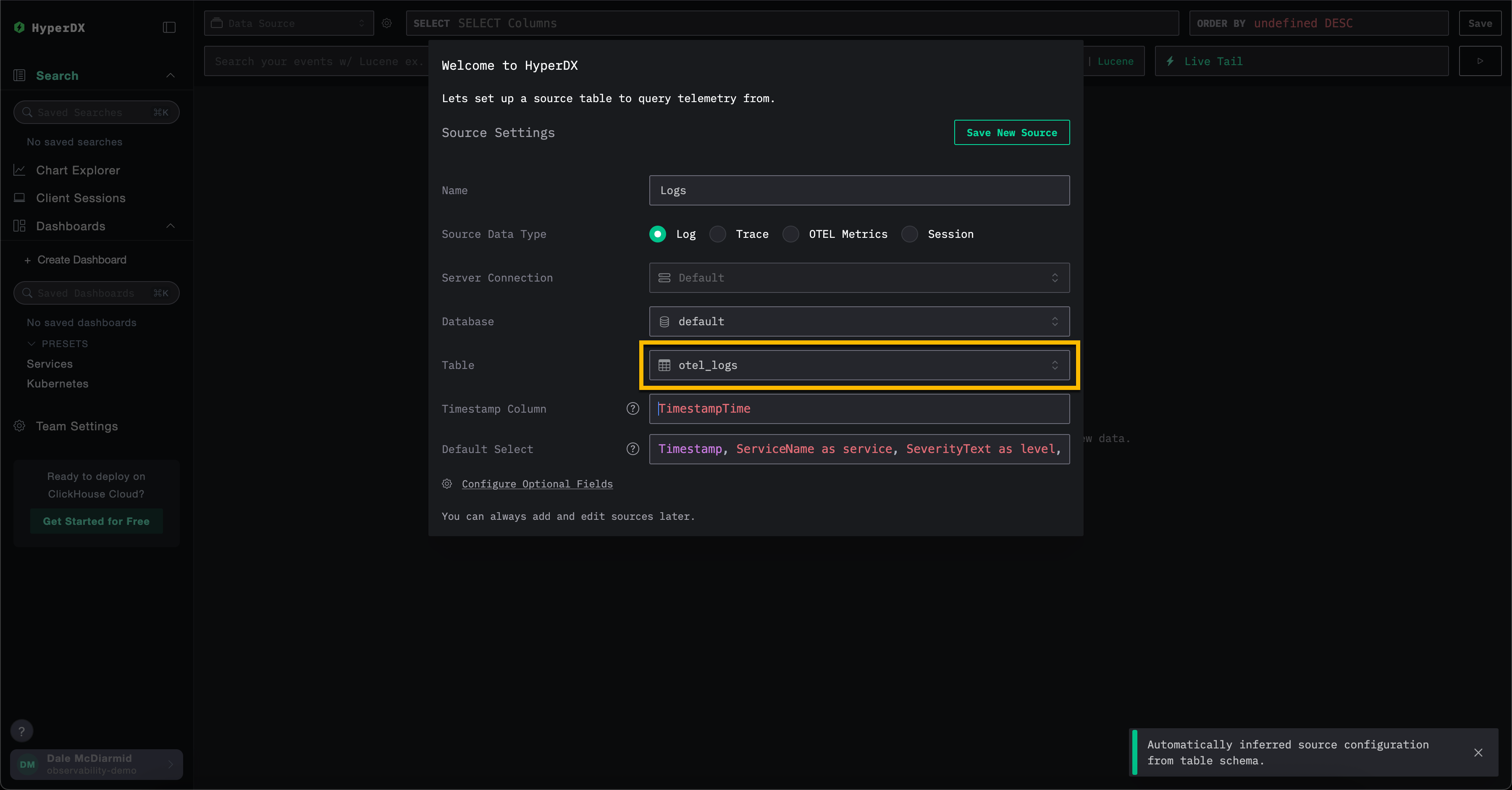

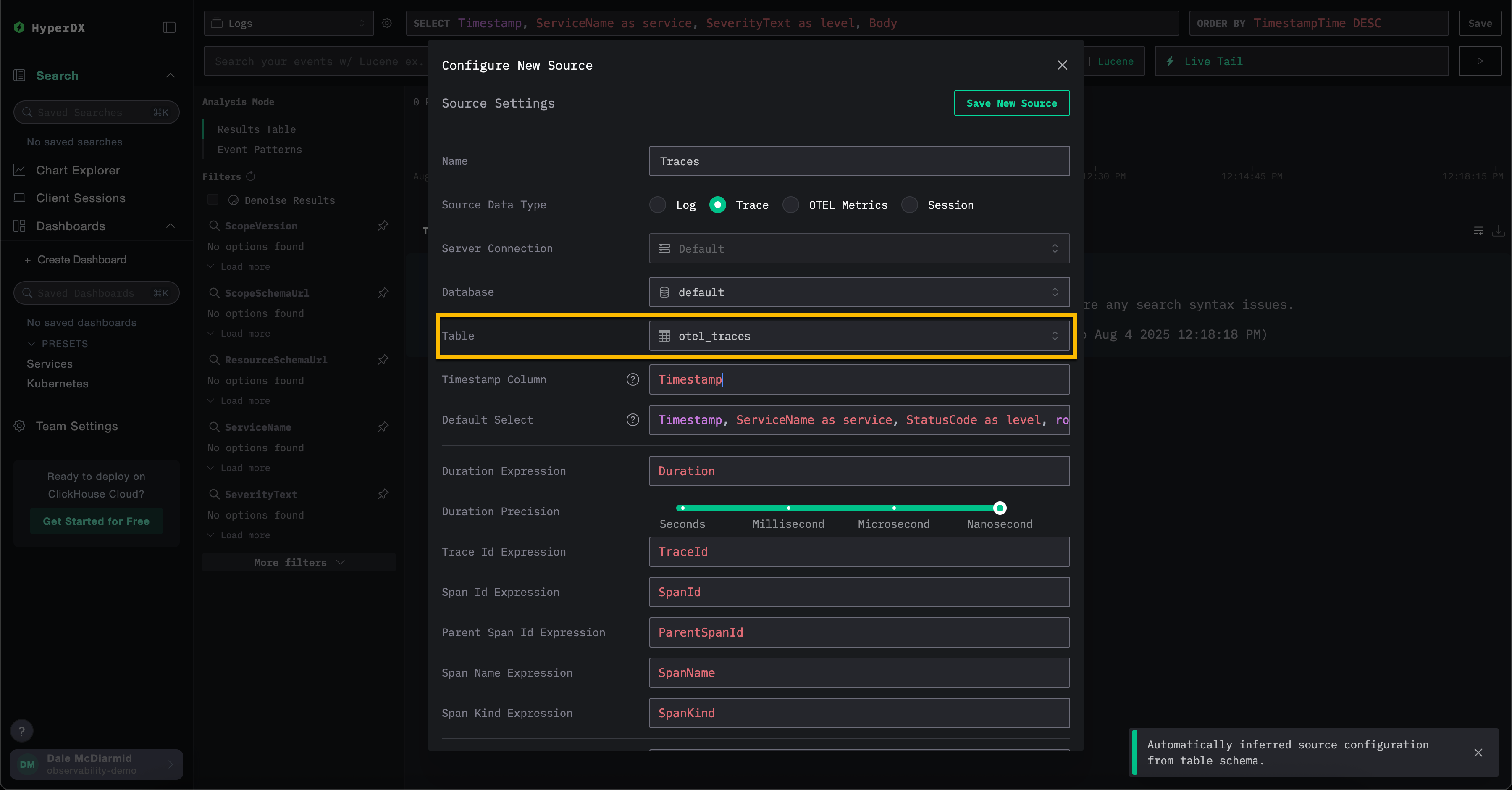

Если вы используете сборщик OTel для создания базы данных и таблиц в ClickHouse, сохраните все значения по умолчанию в модели создаваемого источника, заполнив поле Table значением otel_logs — чтобы создать источник логов. Все другие настройки должны быть автоматически определены, что позволит вам нажать Save New Source.

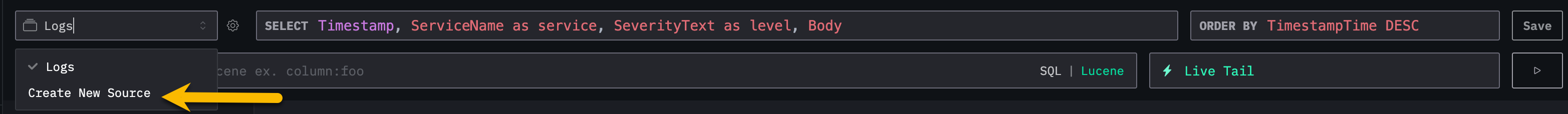

Чтобы создать источники для трассировок и метрик OTel, пользователи могут выбрать Create New Source в верхнем меню.

Отсюда выберите необходимый тип источника, затем соответствующую таблицу, например для трассировок выберите таблицу otel_traces. Все настройки должны быть автоматически определены.

Обратите внимание, что разные источники данных в ClickStack — такие как логи и трассировки — могут быть скоррелированы друг с другом. Чтобы это включить, необходимо дополнительное конфигурирование для каждого источника. Например, в источнике логов вы можете указать соответствующий источник трассировки, и наоборот в источнике трассировок. См. "Скоррелированные источники" для получения дополнительных сведений.

Использование пользовательских схем

Пользователи, желающие подключить HyperDX к существующему сервису с данными, могут завершить настройки базы данных и таблиц по мере необходимости. Настройки будут автоматически определены, если таблицы соответствуют схемам Open Telemetry для ClickHouse.

Если вы используете свою собственную схему, мы рекомендуем создать источник логов, убедившись, что указаны необходимые поля - см. "Настройки источника логов" для получения дополнительных сведений.

Поддержка типа JSON

ClickStack имеет бета-поддержку типа JSON с версии 2.0.4.

Для преимуществ этого типа см. Преимущества типа JSON.

Для включения поддержки типа JSON пользователи должны установить следующие переменные окружения:

OTEL_AGENT_FEATURE_GATE_ARG='--feature-gates=clickhouse.json'- включает поддержку в сборщике OTel, гарантируя, что схемы создаются с использованием типа JSON.

Кроме того, пользователи должны обратиться по адресу support@clickhouse.com, чтобы убедиться, что JSON включен на их сервисе ClickHouse Cloud.